Tin tức AI

Falcon Mamba 7B: Kiến trúc AI mới thách thức các mô hình Transformer

Viện Đổi mới Công nghệ (TII) tại Abu Dhabi, một tổ chức nghiên cứu về các công nghệ tiên tiến như trí tuệ nhân tạo, điện toán lượng tử và robot tự động, vừa phát hành mô hình mã nguồn mở mới mang tên Falcon Mamba 7B.

Falcon Mamba 7B, hiện có sẵn trên Hugging Face, sử dụng kiến trúc Mamba State Space Language Model (SSLM) mới để xử lý các tác vụ tạo văn bản và vượt trội hơn các mô hình hàng đầu cùng kích thước, bao gồm Llama 3 8B, Llama 3.1 8B của Meta và Mistral 7B trong một số điểm chuẩn nhất định.

Đây là mô hình mở thứ tư từ TII sau Falcon 180B, Falcon 40B và Falcon 2, nhưng là mô hình đầu tiên thuộc loại SSLM, một giải pháp thay thế đầy hứa hẹn cho các mô hình ngôn ngữ lớn (LLM) dựa trên Transformer trong lĩnh vực AI.

TII cung cấp mô hình này theo “Giấy phép Falcon 2.0”, một giấy phép cho phép sử dụng dựa trên Apache 2.0.

Falcon Mamba 7B mang đến điều gì mới?

Mặc dù các mô hình Transformer vẫn đang thống trị lĩnh vực AI tạo sinh, các nhà nghiên cứu đã nhận thấy rằng kiến trúc này có thể gặp khó khăn khi xử lý các đoạn văn bản dài.

Về cơ bản, cơ chế attention của Transformer, hoạt động bằng cách so sánh mọi từ (hoặc token) với mọi từ khác trong văn bản để hiểu ngữ cảnh, đòi hỏi nhiều năng lực tính toán và bộ nhớ hơn để xử lý các cửa sổ ngữ cảnh ngày càng lớn.

Nếu tài nguyên không được mở rộng tương ứng, quá trình suy luận sẽ chậm lại và đến một lúc nào đó sẽ không thể xử lý văn bản vượt quá một độ dài nhất định.

Để khắc phục những trở ngại này, kiến trúc State Space Language Model (SSLM), hoạt động bằng cách liên tục cập nhật “trạng thái” khi xử lý từ, đã nổi lên như một giải pháp thay thế đầy hứa hẹn. Kiến trúc này đã được một số tổ chức triển khai và TII là đơn vị áp dụng mới nhất.

Theo TII, mô hình Falcon hoàn toàn mới của họ sử dụng kiến trúc Mamba SSM do các nhà nghiên cứu tại Đại học Carnegie Mellon và Đại học Princeton đề xuất trong một bài báo vào tháng 12 năm 2023.

Kiến trúc này sử dụng cơ chế lựa chọn cho phép mô hình tự động điều chỉnh các tham số dựa trên dữ liệu đầu vào. Bằng cách này, mô hình có thể tập trung hoặc bỏ qua các đầu vào cụ thể, tương tự như cách thức hoạt động của attention trong Transformer, đồng thời mang lại khả năng xử lý các chuỗi văn bản dài – chẳng hạn như toàn bộ một cuốn sách – mà không cần thêm bộ nhớ hoặc tài nguyên tính toán.

Theo TII, cách tiếp cận này giúp mô hình phù hợp với các tác vụ ở cấp độ doanh nghiệp như dịch máy, tóm tắt văn bản, thị giác máy tính và xử lý âm thanh cũng như các tác vụ như ước tính và dự báo.

Đối đầu với Meta, Google và Mistral

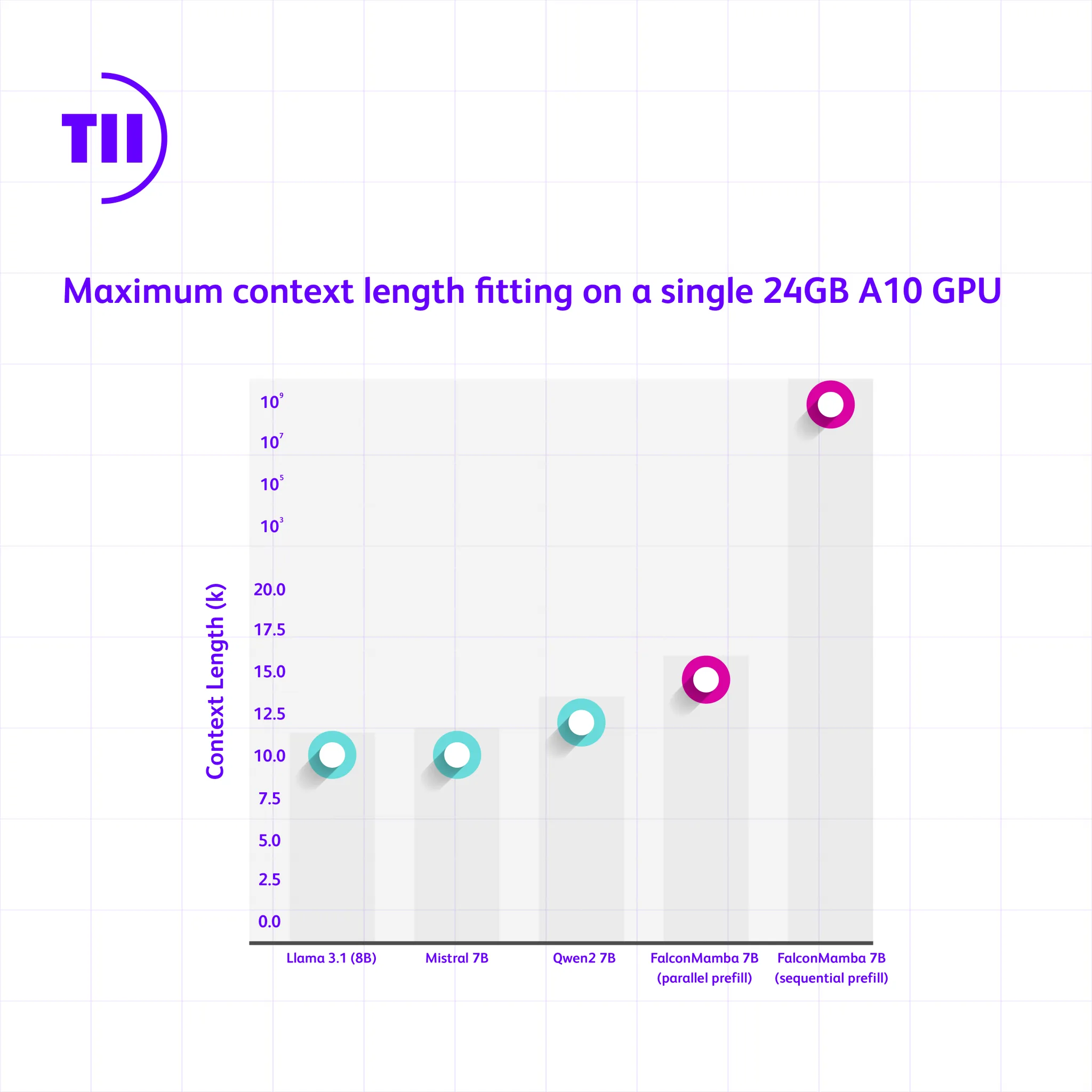

Để xem Falcon Mamba 7B hoạt động như thế nào so với các mô hình Transformer hàng đầu cùng kích thước, viện đã thực hiện một bài kiểm tra để xác định độ dài ngữ cảnh tối đa mà các mô hình có thể xử lý khi sử dụng một A10GPU 24GB duy nhất.

Kết quả cho thấy Falcon Mamba có thể “xử lý các chuỗi dài hơn so với các mô hình dựa trên Transformer tiên tiến nhất (SoTA) trong khi về mặt lý thuyết có thể xử lý độ dài ngữ cảnh vô hạn nếu xử lý toàn bộ ngữ cảnh theo từng token hoặc theo các khối token có kích thước phù hợp với GPU, được gọi là xử lý song song tuần tự.”

Trong một bài kiểm tra thông lượng riêng biệt, nó đã vượt trội hơn kiến trúc attention cửa sổ trượt hiệu quả của Mistral 7B trong việc tạo tất cả các token ở tốc độ không đổi và không làm tăng bộ nhớ CUDA đỉnh.

Ngay cả trong các điểm chuẩn tiêu chuẩn của ngành, hiệu suất của mô hình mới cũng tốt hơn hoặc gần bằng các mô hình Transformer phổ biến cũng như các mô hình không gian trạng thái thuần túy và lai.

Chẳng hạn, trong các điểm chuẩn Arc, TruthfulQA và GSM8K, Falcon Mamba 7B lần lượt đạt 62,03%, 53,42% và 52,54%, vượt trội hơn hẳn Llama 3 8B, Llama 3.1 8B, Gemma 7B và Mistral 7B.

Tuy nhiên, trong các điểm chuẩn MMLU và Hellaswag, nó chỉ bám đuổi sát nút tất cả các mô hình này.

Tuy nhiên, đây mới chỉ là bước khởi đầu. Bước tiếp theo, TII có kế hoạch tiếp tục tối ưu hóa thiết kế của mô hình để cải thiện hiệu suất và bao quát thêm nhiều trường hợp ứng dụng.

“Bản phát hành này đánh dấu một bước tiến quan trọng, truyền cảm hứng cho những góc nhìn mới và tiếp tục thúc đẩy hành trình tìm kiếm các hệ thống thông minh. Tại TII, chúng tôi đang vượt qua ranh giới của cả mô hình SSLM và mô hình Transformer để tạo ra làn sóng đổi mới tiếp theo trong lĩnh vực AI tạo sinh”, Tiến sĩ Hakim Hacid, Quyền Giám đốc Nghiên cứu của đơn vị AI liên ngành của TII, cho biết trong một tuyên bố.

Nhìn chung, họ mô hình ngôn ngữ Falcon của TII đã được tải xuống hơn 45 triệu lần – trở thành một trong những bản phát hành LLM thành công nhất từ UAE.

Falcon Mamba 7B: Sự lựa chọn mở cho cộng đồng AI

Việc phát hành Falcon Mamba 7B theo giấy phép mã nguồn mở là một tin vui cho cộng đồng AI. Điều này cho phép các nhà nghiên cứu và nhà phát triển tự do sử dụng, nghiên cứu và sửa đổi mô hình, từ đó thúc đẩy sự đổi mới và phát triển của công nghệ ngôn ngữ.

Giấy phép Falcon 2.0 cho phép sử dụng Falcon Mamba 7B trong cả mục đích thương mại, tạo điều kiện thuận lợi cho các doanh nghiệp và tổ chức muốn khai thác sức mạnh của mô hình này để xây dựng các ứng dụng và dịch vụ tiên tiến.

Tương lai của Mô hình Ngôn ngữ: SSLM vs. Transformer

Mặc dù còn quá sớm để khẳng định SSLM sẽ thay thế hoàn toàn Transformer, nhưng những kết quả ban đầu của Falcon Mamba 7B cho thấy tiềm năng to lớn của kiến trúc này.

Khả năng xử lý văn bản dài và hiệu suất vượt trội của SSLM có thể mở ra những hướng đi mới cho ngành AI, đặc biệt là trong bối cảnh lượng dữ liệu văn bản ngày càng tăng như hiện nay.

TII cam kết tiếp tục đầu tư vào nghiên cứu và phát triển Falcon Mamba cũng như các mô hình SSLM khác. Việc cạnh tranh giữa SSLM và Transformer được kỳ vọng sẽ mang đến những bước đột phá mới cho lĩnh vực AI tạo sinh trong tương lai gần.

Kết luận

Falcon Mamba 7B là một minh chứng cho sự tiến bộ không ngừng của công nghệ AI. Mô hình này không chỉ mang đến một giải pháp thay thế đầy hứa hẹn cho các mô hình Transformer truyền thống mà còn góp phần thúc đẩy sự phát triển của cộng đồng AI thông qua việc phát hành mã nguồn mở.

Falcon Mamba 7B hứa hẹn sẽ mở ra nhiều ứng dụng và dịch vụ AI tiên tiến hơn trong tương lai, đồng thời đặt nền móng cho những đột phá mới trong lĩnh vực xử lý ngôn ngữ tự nhiên.